Pstage3_Image_Segmentation_Detection

Image Segmentation

https://github.com/bcaitech1/p3-ims-obd-hansarang

Overview

문제정의 : 쓰레기가 찍힌 사진에서 쓰레기를 Segmentation

Pstage2_KLUE

문장내 개체관 관계 추출

뭔가 아쉬웠던 P-stage 2 KLUE가 끝이 났다.

이번 stage에서는 리더보드 순위를 올리는데에만 집중하기 보다는 다양한 task를 써보고 원리를 이해하고 결과를 토론계시판에 꼭 조금이라도 공유하는 방식으로 하기로 마음먹었었다.

Image Classification

K Nearest Neighbors (k-NN)

기존의 data가 가지고있는 label을 활용해서 새로운 data의 label을 분류하는 문제가 된다. 이렇게 된다면 미리 유사도를 정의해야 한다. 그리고 system 복잡도가 너무 높다. 따라서 data를 NN의 parameter에 녹여넣는 것이다.

Yann Lecun의 CNN 개발 : 우편번호인식에 혁신을 이루어냄

Using better activation function

annotation data의 효율적인 학습 기법

data 부족문제의 완화 : 대표적인 방법들

- Data augmentation

- Leveraging pre-trained information

- Leveraging unlabeled dataset for training

Graph2

검색엔진에서의 그래프

페이지랭크의 배경

1.1 웹과 그래프

웹(방향성이 있는 그래프) = 웹페이지(node) + 하이퍼링크(edge)

웹페이지는 추가적으로 키워드 정보를 포함하고있다.

2.2 구글이전의 검색엔진

웹을 거대한 디렉토리로 정리

웹페이지의 수가 증가함에 따라 카테고리 수도 무한정 커지는 문제가 있다

카테고리 분류가 모호할수가 있다.

키워드에 의존한 검색엔진

악의적인 웹피이지에 취약하다

Graph

그래프란 정점과 간선으로 이루어진 구조

하나의 간선은 반드시 두개의 정점을 연결한다

정점 : vertex,node

간선 : Edge,link

우리의 사회및 모든 다양한 것들은 구성요소간의 복잡한 살호작용으로 이루어진 복잡계이다

이것을 표현하는 방식이 바로 그래프이다

그래프란 복잡계를 간단하게 표현하는 방식이다

Transformer심화

Transformer

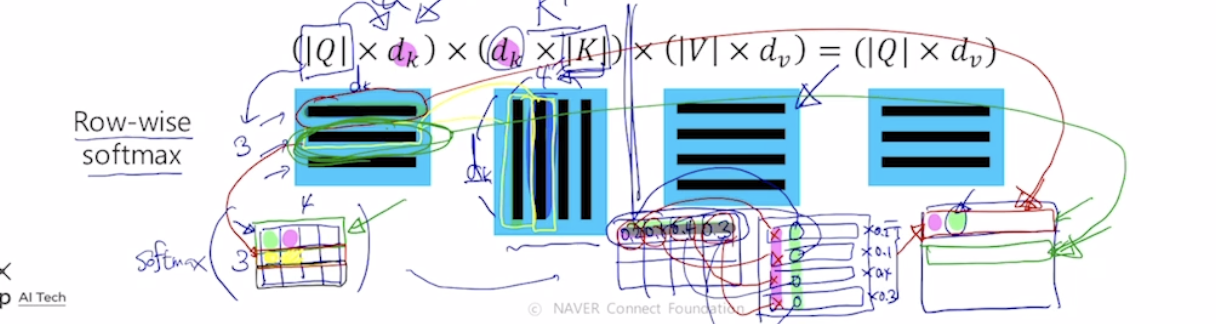

Self-Attention

ex) I go home

I에 대한 input vector가 hidden state처럼 역할을 하여서

I와 각각의 단어에 대한 내적을 한후 이에대한 softmax를 구하여 가중평균을 구한다.

이렇게 encoding vector값을 구하게 되면 결국 자기자신과 내적한 값이 큰값을 가져, 자기 자신에 대한 특성만이 dominant하게 담길것이므로, 이를 해결해주기 위해 다른 architecture를 쓴다

각 vector들이 3가지의 역할을 하고있는 것이다. 동일한 set의 vector에서 출발했더라도 각혁할에 따라 vector가 서로다른형태로 변환할수있게해주는 linear transformation matrix가 있다.

한마디로 각각의 input이 서로다른 matrix에 적용이되어 각각이 key, quary,value가 된다는 의미이다.

I 라는 word가 서로다른 matrix에 따라 quart, key, value값이 만들어지고 쿼리는 1개이고 이 쿼리 벡터와 각각의 key vector와의 내적값을 구하고 결과를 softmax에 통과시켜 가중치를 구한후 , 이값과 value vector를 각각 곱해주어 이들의 가중평균으로 최종적인 vector를 구하다. 결국 이 vector가 feature들이 담긴 encoding vector이다.

이러하게 행렬연산으로 위의 과정을 한번에 처리할 수 있다.

Sequence to sequence with Attention

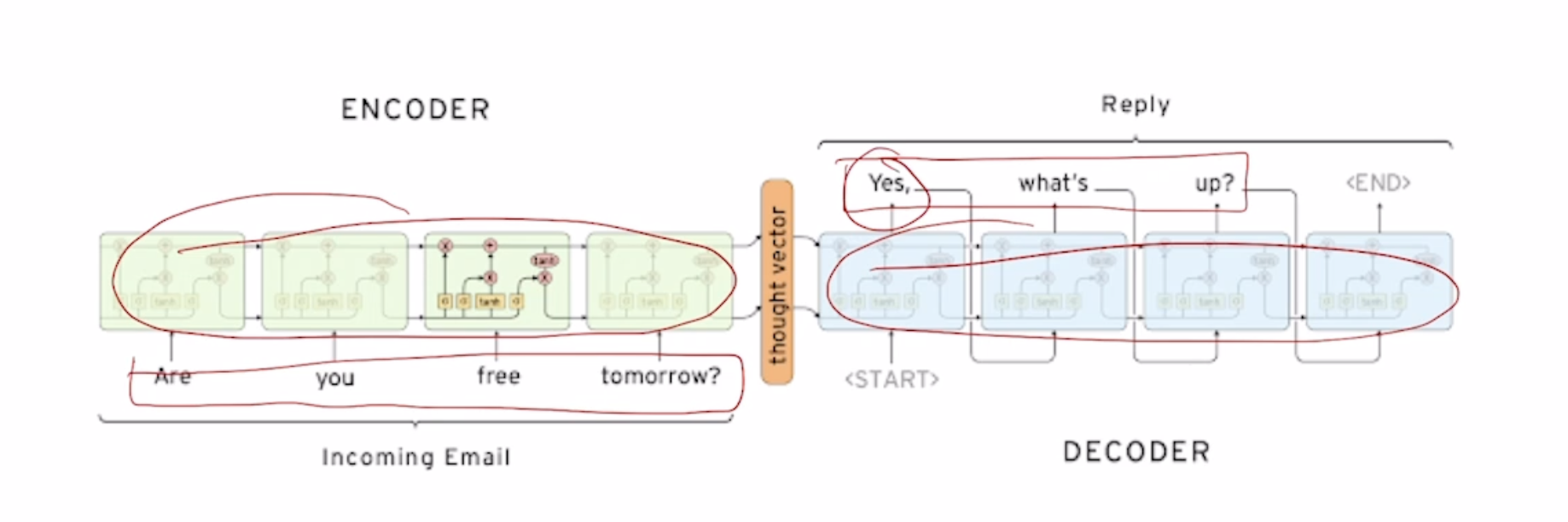

Sequence to sequence

\

Seq2Seq Model

Ex) Are you free tomorrow?

서로 paramter를 share하지 않는 2개의 별개의 RNN model을 (보통 LSTM) 쓴다. 각각의 RNN을 Decoder, Encoder로 사용한다.

Encoder의 마지막단의 output을 vertorize 시켜준후 decoder의 input에는 SOS token, hidden state에는 encoder의 output을 넣어준다.

RNN심화1

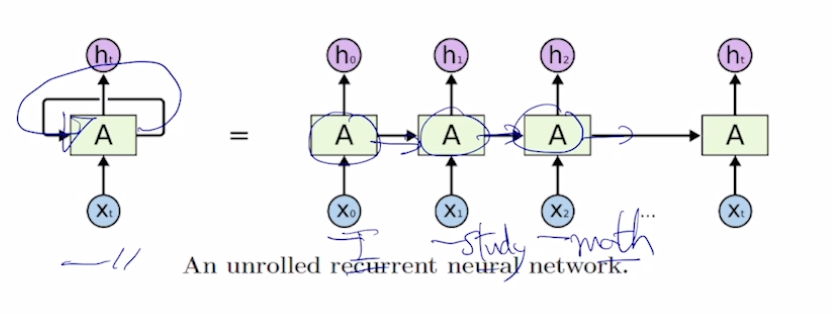

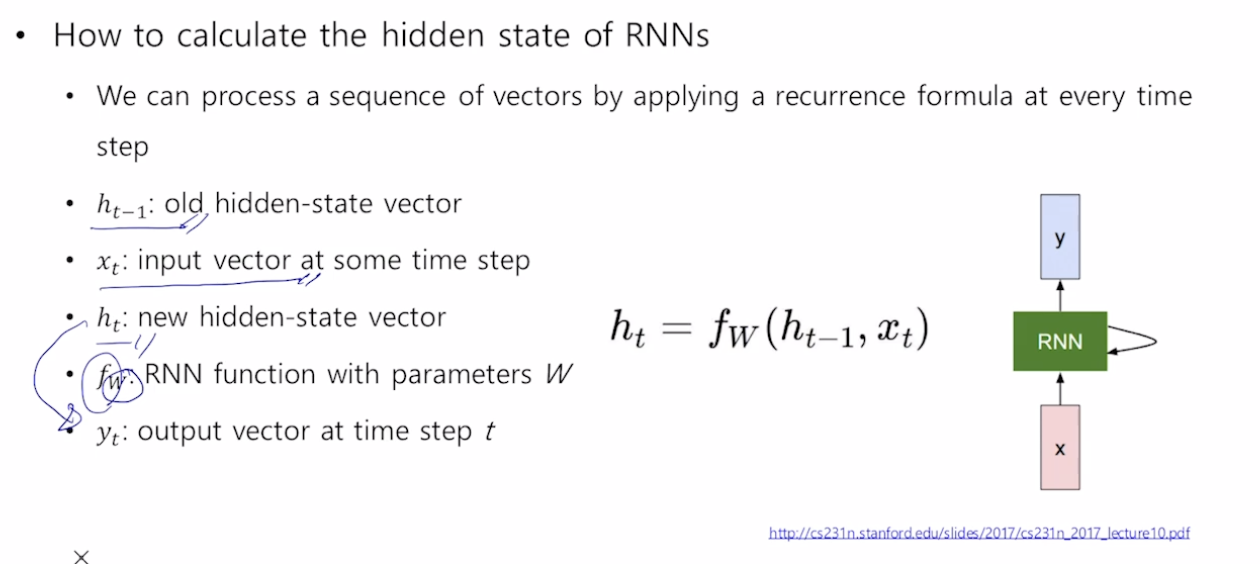

RNN

서로다른 time step에서 들어오는 입력 데이터를 처리할때, 매번 반복되는 동일한 rnn module을 호출한다.

각 단어별로 품사를 예측해야 되는 경우 -> 매 time step마다 y를 output으로

어떠한 문장의 긍부정을 판별하는 경우 -> 최종 time step의 y만이 output으로

모든 time step에서 같은 parameter W를 공유한다

Generative Models

Generative Models

- What I can not create, I do not understand

https://deepgenerativemodels.github.io/

Introduction

- What does it mean to learn a generative model

- generative model은 단순히 생성모델이 아니다

Suppose we have some images of dogs

We want to learn a probability distribution p(x) such that

Generation : If we sample x

new~ p(x), xnewshould look like a dog- implicit models

Density estimation :p(x) should be high if x look like a dog (어떤이미지의 확률을 계산함)

이건 마치 image classification

- explicit models

Unsupervised representation learning

특정 image가 어떤 특징을 가지고있는지를 학습