Generative Models

Generative Models

- What I can not create, I do not understand

https://deepgenerativemodels.github.io/

Introduction

- What does it mean to learn a generative model

- generative model은 단순히 생성모델이 아니다

Suppose we have some images of dogs

We want to learn a probability distribution p(x) such that

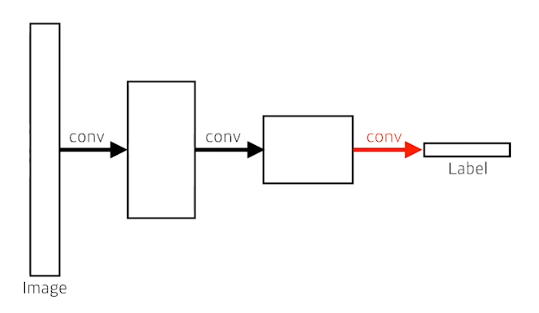

Generation : If we sample x

new~ p(x), xnewshould look like a dog- implicit models

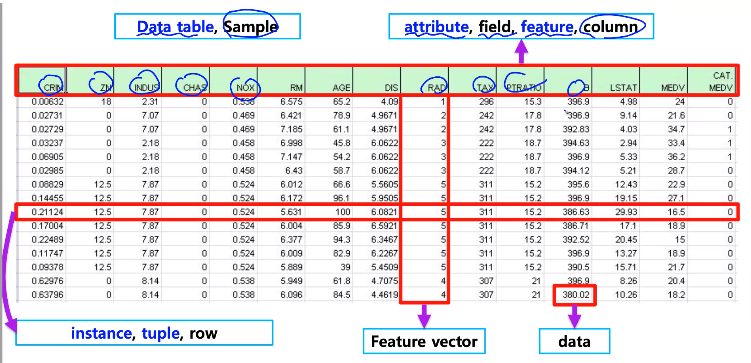

Density estimation :p(x) should be high if x look like a dog (어떤이미지의 확률을 계산함)

이건 마치 image classification

- explicit models

Unsupervised representation learning

특정 image가 어떤 특징을 가지고있는지를 학습